Docker 安装prometheus、grafana

docker安装prometheus和grafana

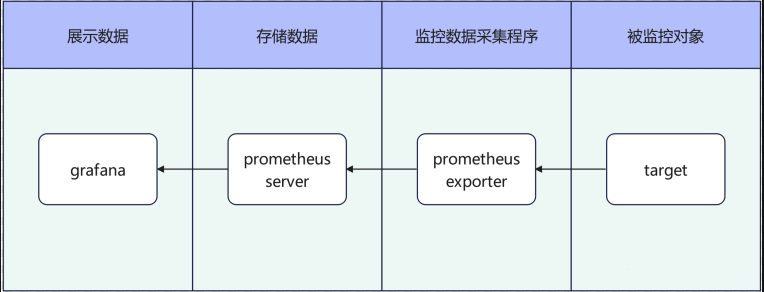

概念简述

-

prometheus([普罗米修斯]):天生为采集存储监控数据而生的时序数据库。prometheus通过各种Exporter采集到监控数据,然后存储进prometheus中,以供查询展示

-

grafana:一个监控仪表系统。grafana的数据来源可以有很多(如:Prometheus、Graphite、OpenTSDB、InfluxDB、MySQL/PostgreSQL、Microsoft SQL Serve等等),其中用得最多的数据源是prometheus

注:prometheus也有自己的UI,不过功能没有grafana强大

安装prometheus

1、拉取镜像

docker pull prom/prometheus:v2.41.0

# 当然也可以docker pull prom/prometheus:lastest,直接拉取最新版本

2、创建挂载目录及文件

- 准备目录

# /usr/local/prometheus/data目录,准备用来挂载放置prometheus的数据

# /usr/local/prometheus/config目录,准备用来放置prometheus的配置文件

# /usr/local/prometheus/rules目录,准备用来挂载放置prometheus的规则文件

mkdir -p /usr/local/prometheus/{data,config,rules}

# 授权相关文件夹权限

chmod -R 777 /usr/local/prometheus/data

chmod -R 777 /usr/local/prometheus/config

chmod -R 777 /usr/local/prometheus/rules

12345678

- 配置文件

vim /usr/local/prometheus/config/prometheus.yml

# 配置文件

global:

# 数据采集间隔

scrape_interval: 45s

# 告警检测间隔

evaluation_interval: 45s

# 告警规则

rule_files:

# 这里匹配指定目录下所有的.rules文件

- /prometheus/rules/*.rules

# 采集配置

scrape_configs:

# 采集项(prometheus)

- job_name: 'prometheus'

static_configs:

# prometheus自带了对自身的exporter监控程序,所以不需额外安装exporter就可配置采集项

- targets: ['localhost:9090']

# - job_name: 'xxx-exporter'

# static_configs:

#- targets: ['ip:9090']

prometheus配置项说明

- global:全局配置 (如果有内部单独设定,会覆盖这个参数)

- alerting:告警插件定义。这里会设定alertmanager这个报警插件

- rule_files:告警规则。 按照设定参数进行扫描加载,用于自定义报警规则,其报警媒介和route路由由alertmanager插件实现

- scrape_configs:采集配置。配置数据源,包含分组job_name以及具体target。又分为静态配置和服务发现

- remote_write:用于远程存储写配置

- remote_read:用于远程读配置

3、启动容器

# 启动prometheus

# config.file:指定容器中,配置文件的位置

# web.enable-lifecycle:启动此项后,当配置文件发生变化后,可通过HTTP API 发送 post 请求到 /-/reload,实现热加载,如:curl -X POST http://47.105.39.189:9090/-/reload

# -v /etc/localtime:/etc/localtime:ro表示让容器使用宿主机的时间, :ro表示只读(注:此方式只针对宿主机和容器的时区文件均为/etc/localtime)

docker run --name prometheus -d \

-p 9090:9090 \

-v /etc/localtime:/etc/localtime:ro \

-v /usr/local/prometheus/data:/prometheus/data \

-v /usr/local/prometheus/config:/prometheus/config \

-v /usr/local/prometheus/rules:/prometheus/rules \

prom/prometheus:v2.41.0 --config.file=/prometheus/config/prometheus.yml --web.enable-lifecycle

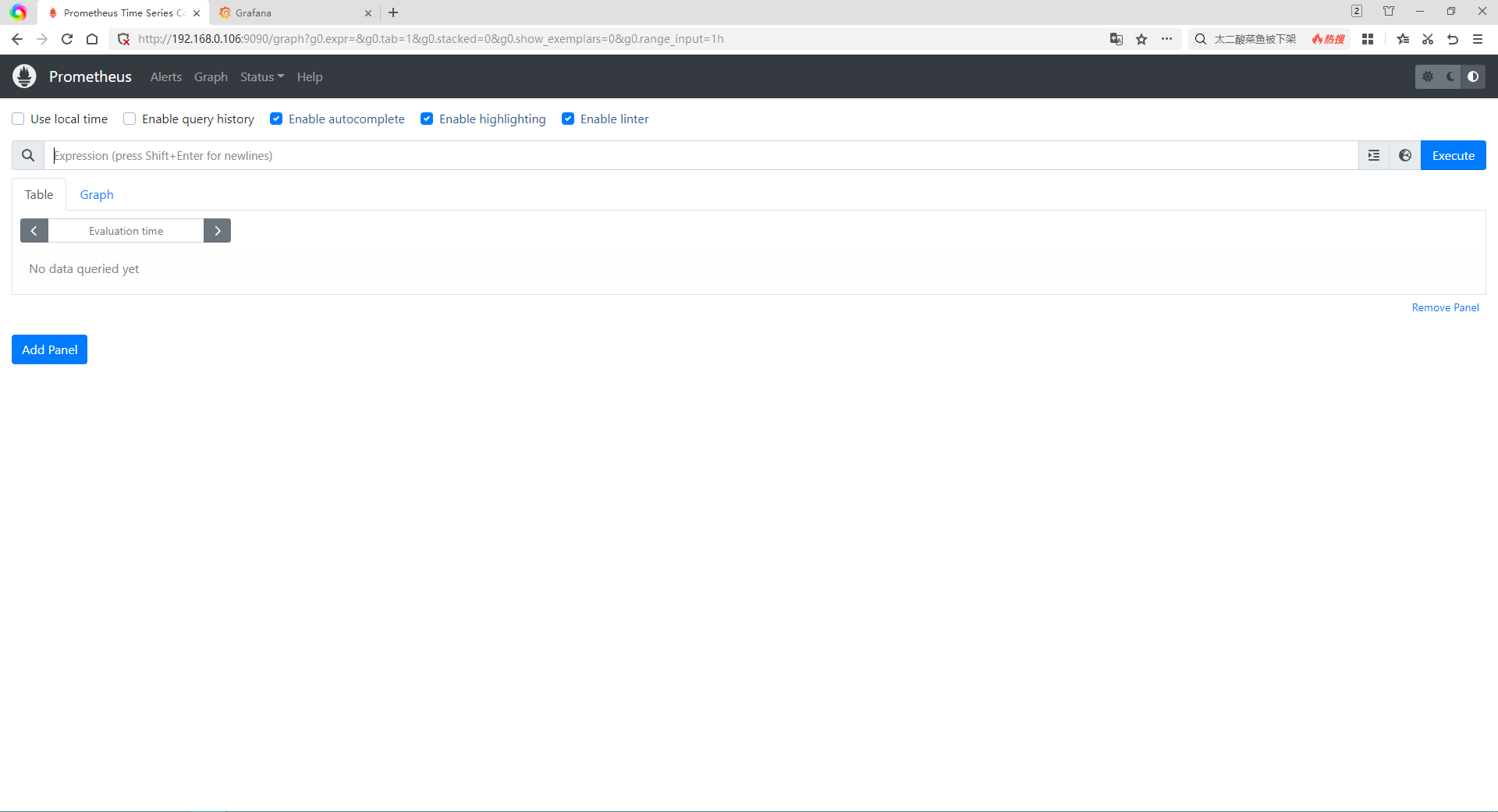

4、访问测试

访问{ip}:9090即可

安装grafana

1、拉取镜像

docker pull grafana/grafana:9.3.2

# 当然也可以docker pull grafana/grafana:lastest,直接拉取最新版本

2、准备相关挂载目录及文件

- 准备目录

# /usr/local/grafana/data目录,准备用来挂载放置grafana的数据

# /usr/local/grafana/plugins目录,准备用来放置grafana的插件

# /usr/local/grafana/config目录,准备用来挂载放置grafana的配置文件

mkdir -p /usr/local/grafana/{data,plugins,config}

# 授权相关文件夹权限

chmod -R 777 /usr/local/grafana/data

chmod -R 777 /usr/local/grafana/plugins

chmod -R 777 /usr/local/grafana/config

- 准备配置文件

# 先临时启动一个容器

docker run --name grafana -d -p 3000:3000 grafana/grafana:9.3.2

# 将容器中默认的配置文件拷贝到宿主机上

docker cp grafana:/etc/grafana/grafana.ini /usr/local/grafana/config/grafana.ini

# 移除临时容器

docker stop grafana

docker rm grafana

# 如需要修改默认配置的话

vim /usr/local/grafana/config/grafana.ini

3、启动容器

# 启动prometheus

# 环境变量GF_SECURITY_ADMIN_PASSWORD:指定admin的密码

# 环境变量GF_INSTALL_PLUGINS:指定启动时需要安装得插件

# grafana-clock-panel代表时间插件

# grafana-simple-json-datasource代表json数据源插件

# grafana-piechart-panel代表饼图插件

docker run -d \

-p 3000:3000 \

--name=grafana \

-v /etc/localtime:/etc/localtime:ro \

-v /usr/local/grafana/data:/var/lib/grafana \

-v /usr/local/grafana/plugins/:/var/lib/grafana/plugins \

-v /usr/local/grafana/config/grafana.ini:/etc/grafana/grafana.ini \

-e "GF_INSTALL_PLUGINS=grafana-clock-panel,grafana-simple-json-datasource,grafana-piechart-panel" \

-e "GF_SECURITY_ADMIN_PASSWORD=admin" \

grafana/grafana:9.3.2

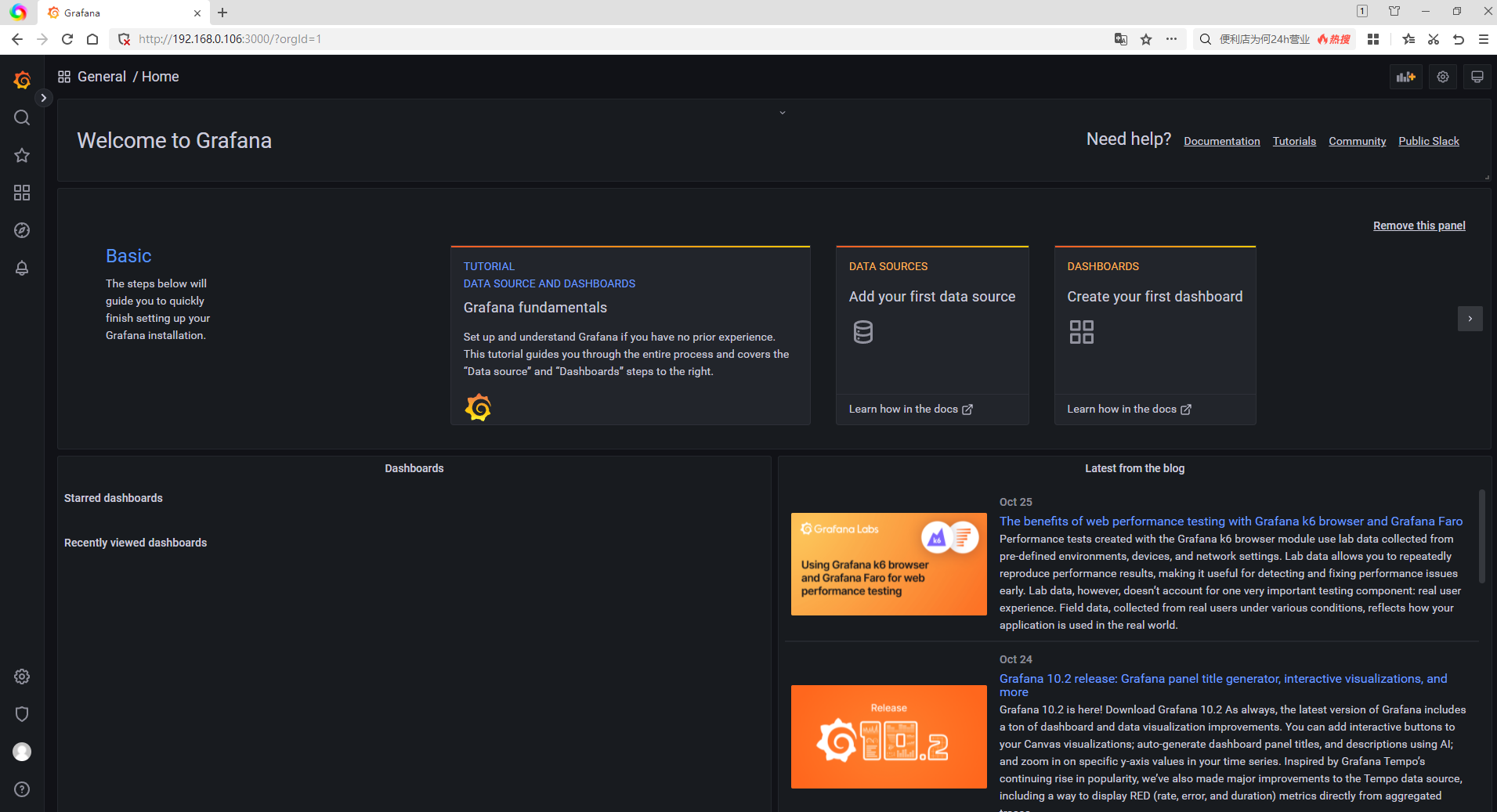

4、访问测试

访问{ip}:3000即可,使用账密admin/admin进行登录即可

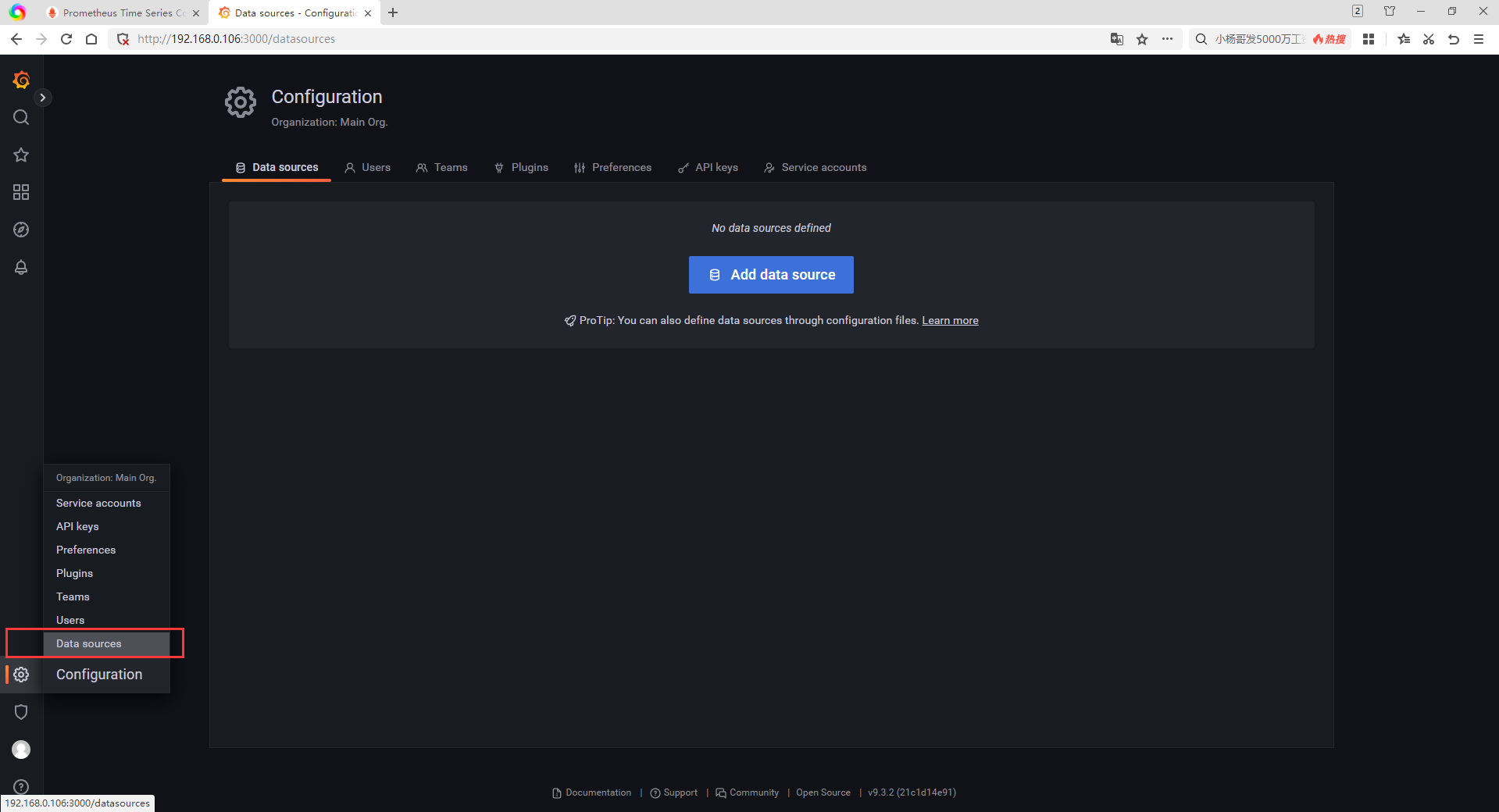

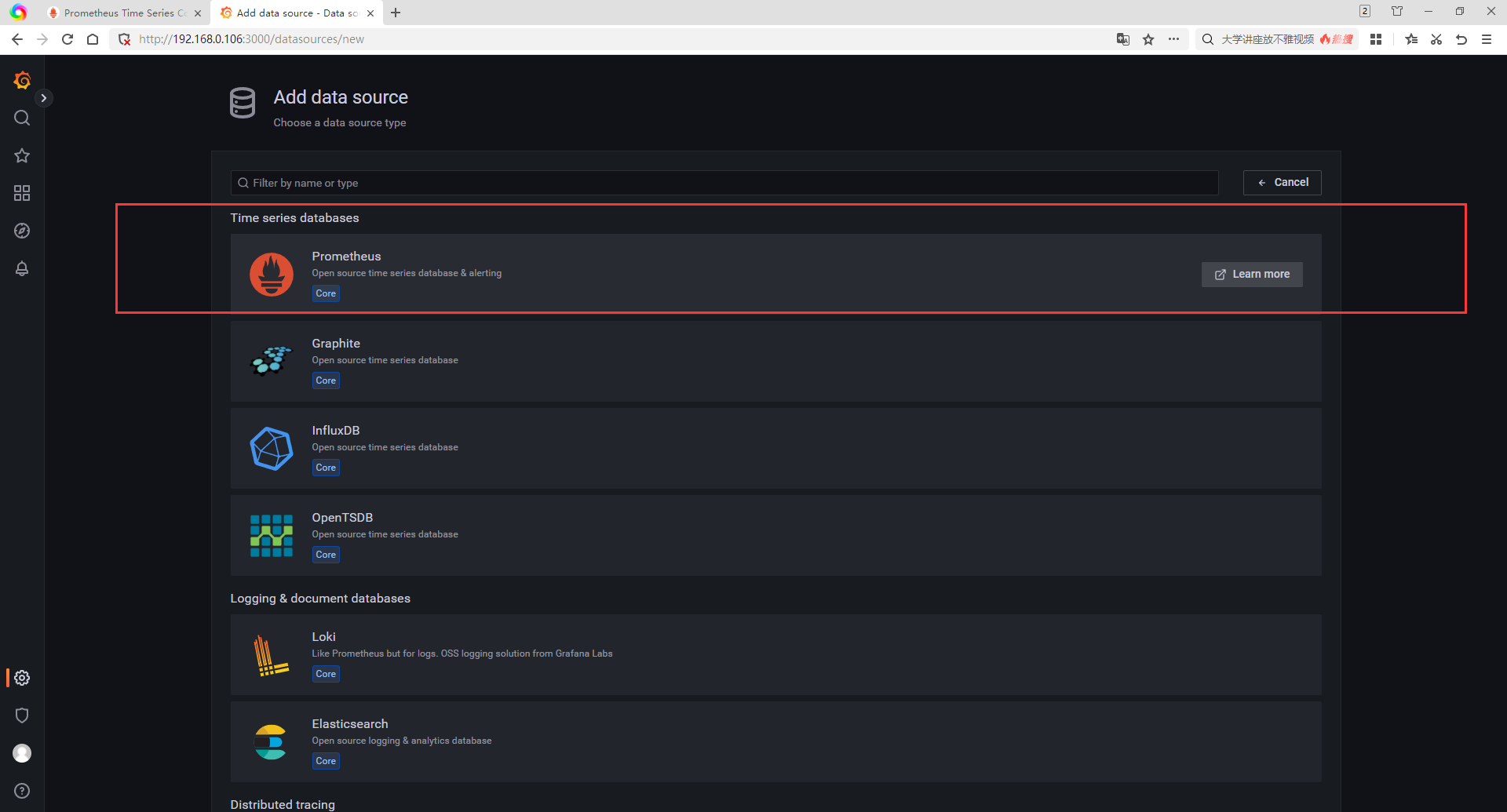

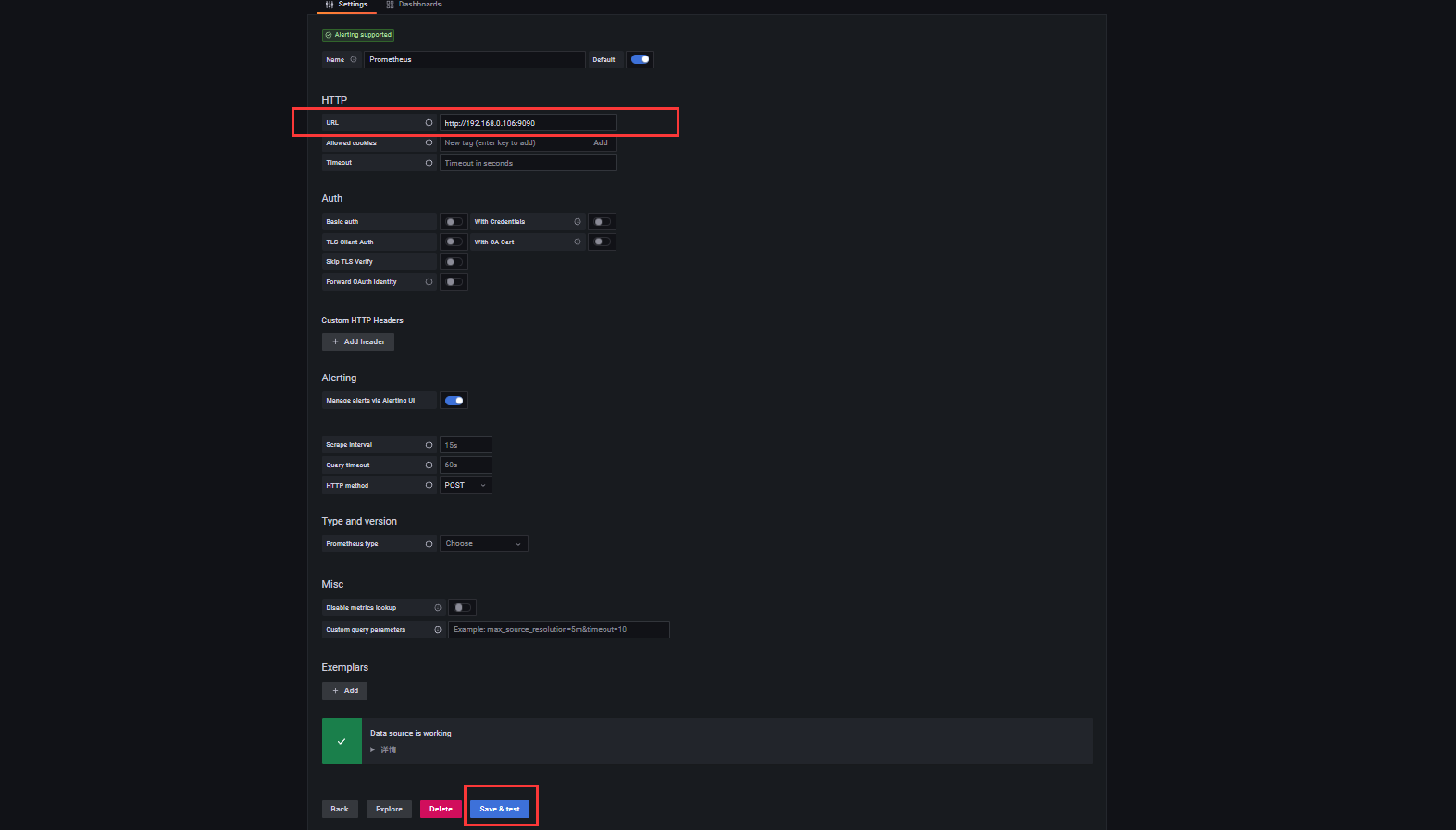

5、配置

-

- 添加数据源

-

-

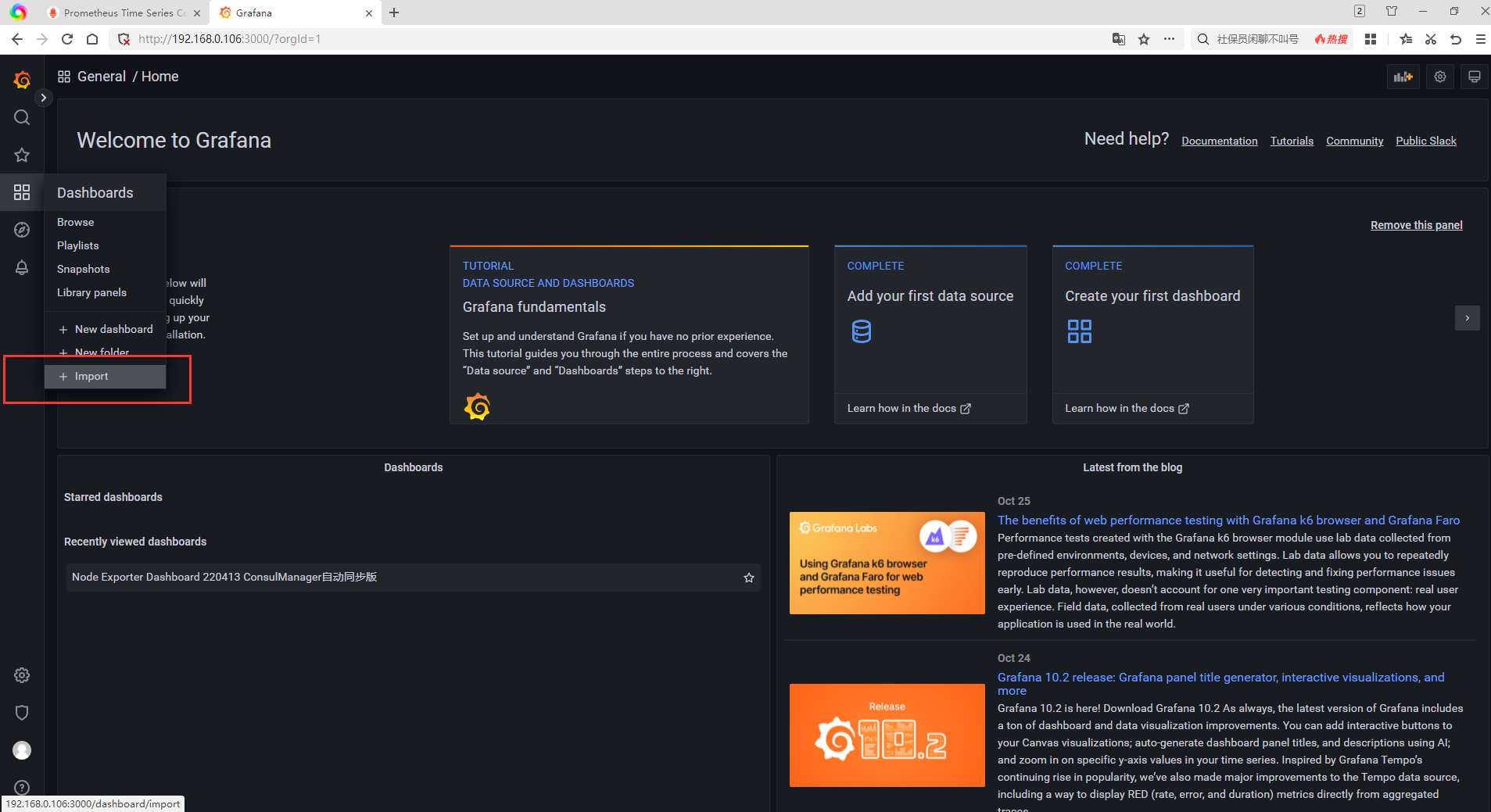

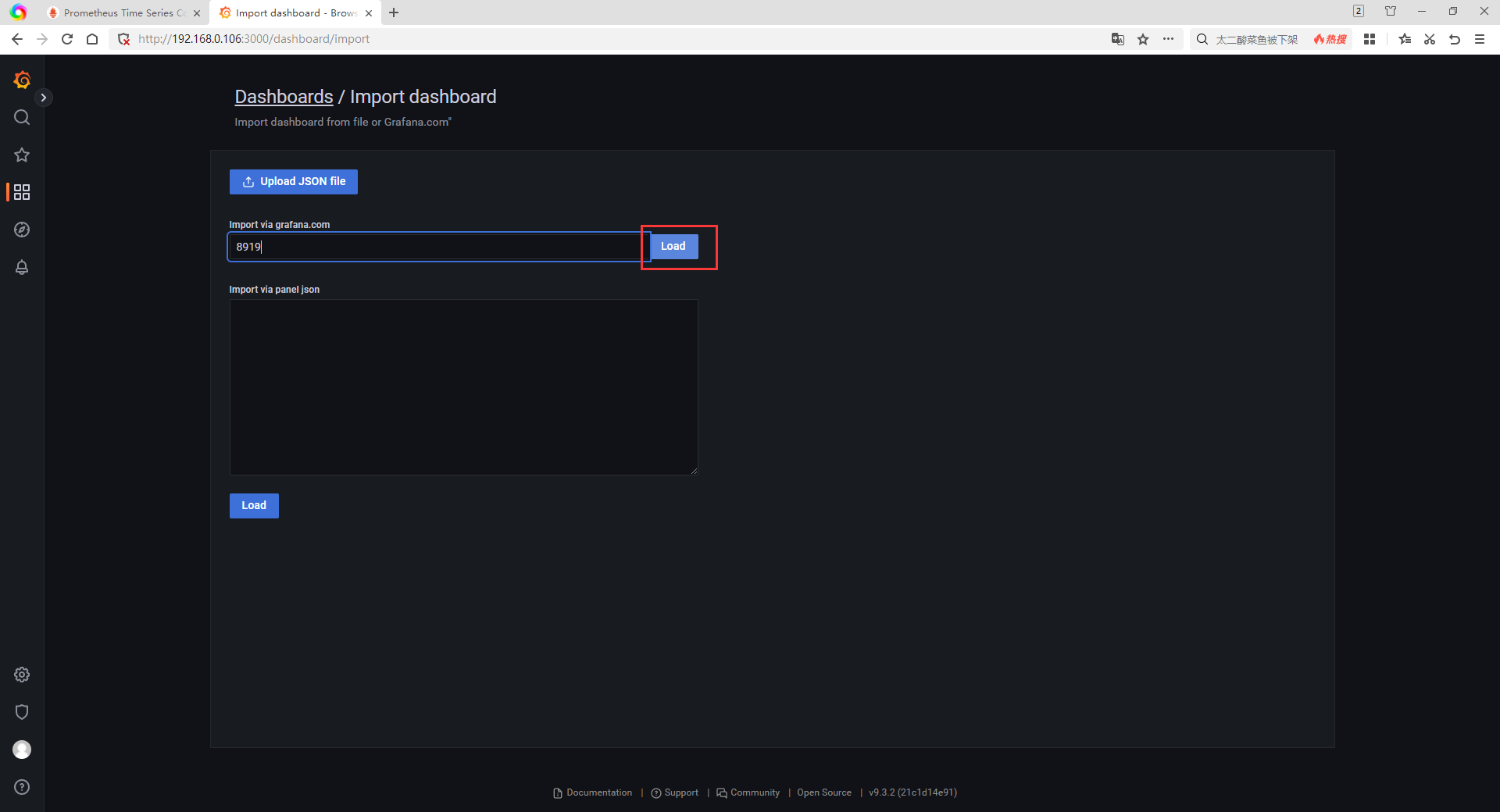

配置仪表盘

grafana官网提供了很多模板,选择你喜欢的样式,直接输入Dashboard Id即可直接导入

-

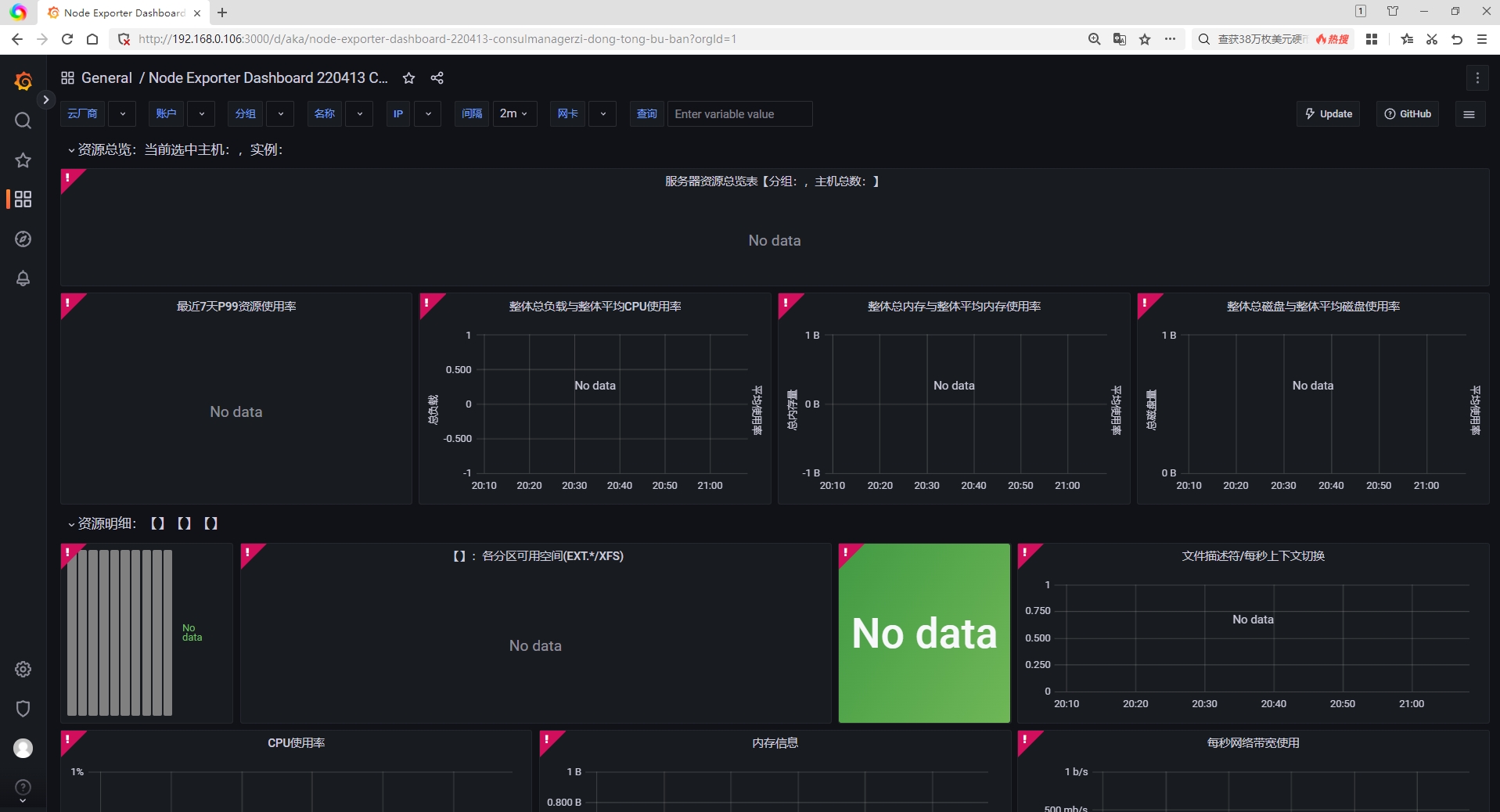

此时,这会儿还没有数据,是因为prometheus里面本来就没有数据,后面我们只需要使用相应的exporter往prometheus录入一些监控数据(如:安装node-exporter)

6、安装exporter监控采集程序

prometheus支持多种exporter采集,以下只讲解node-exporter,其实配置都大差不差。只需要采集的服务器上安装exporter采集程序,在prometheus中配置中集成即可。

node-exporter

官方不建议通过Docekr方式部署node-exporter,因为它需要访问主机系统

node-exporter 可以采集机器(物理机、虚拟机、云主机等)的监控指标数据,能够采集到的指标包括 CPU, 内存,磁盘,网络,文件数等信息

-

1、安装node-exporter

# 下载 wget https://github.com/prometheus/node_exporter/releases/download/v1.1.2/node_exporter-1.1.2.linux-amd64.tar.gz # 解压 tar -xvf node_exporter-1.1.2.linux-amd64.tar.gz cd node_exporter-1.1.2.linux-amd64 # 启动 nohup ./node_exporter --web.listen-address=":9100" & -

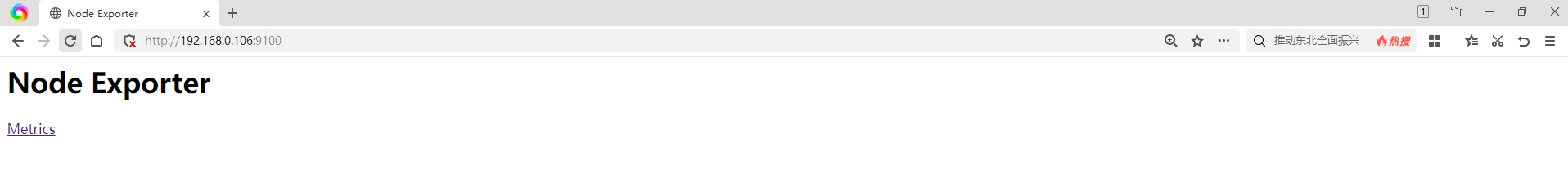

2、访问一下

ip:9100进行验证,确保node-exporter已正常启动

-

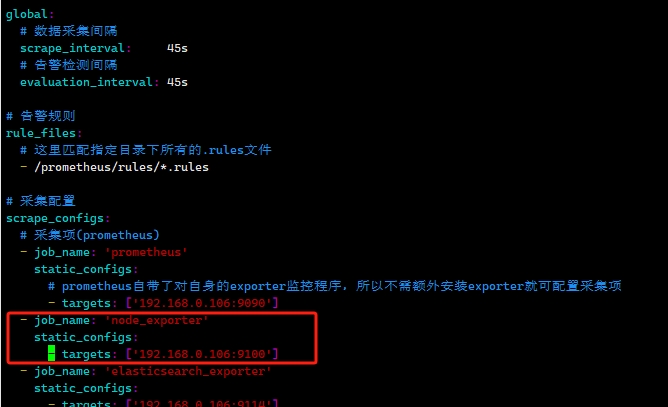

3、在prometheus中配置当前采集项

编辑配置文件vim /usr/local/prometheus/config/prometheus.yml- job_name: 'node_exporter' static_configs: - targets: ['192.168.0.106:9100']

-

4、使得最新的prometheus配置生效

你可以重启prometheus或者使用热加载使新配置生效,这里我们使用热加载的方式

# 前提条件:启动prometheus时,启用了web.enable-lifecycle # 发送post请求到prometheus的/-/reload下触发热加载配置 curl -X POST http://192.168.0.106:9090/-/reload注:若你触发热加载后,过个一会儿还没看到监控的变化, 那么你可以使用

docker logs {prometheus容器}查看prometheus日志,看到底是否触发了热加载 -

5、验证一下

此时,我们再在grafana上看监控面板,就会发现有数据了

安装alertmanager,集成prometheus

1、拉取镜像

docker pull prom/alertmanager:v0.25.0

# 当然也可以docker pull grafana/grafana:lastest,直接拉取最新版本

2、准备相关挂载目录及文件

- 准备目录

# /usr/local/alertmanager/config目录,准备用来放置alertmanager的配置文件

# /usr/local/alertmanager/template目录,准备用来挂载放置alertmanager的模板文件

mkdir -p /usr/local/alertmanager/{config,template}

# 授权相关文件夹权限

chmod -R 777 /usr/local/alertmanager/config

chmod -R 777 /usr/local/alertmanager/template

- 准备配置文件

vim /usr/local/alertmanager/config/alertmanager.yml

# 配置文件

global:

resolve_timeout: 5m

# 发件人

smtp_from: '972304448@qq.com'

# 邮箱服务器的 POP3/SMTP 主机配置 smtp.qq.com 端口为 465 或 587

smtp_smarthost: 'smtp.qq.com:465'

# 用户名

smtp_auth_username: '972304448@qq.com'

# 授权码 或 密码

smtp_auth_password: '你的qq授权码'

smtp_require_tls: false

smtp_hello: 'qq.com'

templates:

# 指定预警内容模板

- '/etc/alertmanager/template/email.tmpl'

route:

# 指定通过什么字段进行告警分组(如:alertname=A和alertname=B的将会被分导两个组里面)

group_by: ['alertname']

# 在组内等待所配置的时间,如果同组内,5 秒内出现相同报警,在一个组内出现

group_wait: 5s

# 如果组内内容不变化,合并为一条警报信息,5 分钟后发送

group_interval: 5m

# 发送告警间隔时间 s/m/h,如果指定时间内没有修复,则重新发送告警

repeat_interval: 5m

# 默认的receiver。 如果一个报警没有被任何一个route匹配,则发送给默认的接收器

receiver: 'liufanQQEmail'

#子路由(上面所有的route属性都由所有子路由继承,并且可以在每个子路由上进行覆盖)

routes:

# 当触发当前预警的prometheus规则满足:标签alarmClassify的为normal时(标签名、标签值可以自定义,只要和编写的prometheus的rule里面设置的标签呼应上即可),往liufanQQEmail发送邮件

- receiver: liufanQQEmail

match_re:

alarmClassify: normal

# 当触发当前预警的prometheus规则满足:标签alarmClassify的值为special时(标签名、标签值可以自定义,只要和编写的prometheus的rule里面设置的标签呼应上即可),往liufanQQEmail发送邮件

- receiver: liufan163Email

match_re:

alarmClassify: special

receivers:

- name: 'liufanQQEmail'

email_configs:

# 如果想发送多个人就以 ',' 做分割

- to: '751531120@qq.com'

send_resolved: true

# 接收邮件的标题

headers: {Subject: "alertmanager报警邮件"}

- name: 'liufan163Email'

email_configs:

# 如果想发送多个人就以 ',' 做分割

- to: '13157191080@163.com'

send_resolved: true

# 接收邮件的标题

headers: {Subject: "alertmanager报警邮件"}

inhibit_rules:

- source_match:

severity: 'critical'

target_match:

severity: 'warning'

equal: ['alertname', 'dev', 'instance']

- 预警内容模板文件

vim /usr/local/alertmanager/template/email.tmpl

# 因为我们进行了挂载,所以我们只需编辑宿主机上的模板文件即可

{{ define "email.html" }}

<table border="1">

<tr>

<td>报警项</td>

<td>实例</td>

<td>报警阀值</td>

<td>开始时间</td>

<td>告警信息</td>

</tr>

{{ range $i, $alert := .Alerts }}

<tr>

<td>{{ index $alert.Labels "alertname" }}</td>

<td>{{ index $alert.Labels "instance" }}</td>

<td>{{ index $alert.Annotations "value" }}</td>

<td>{{ $alert.StartsAt }}</td>

<td>{{ index $alert.Annotations "description" }}</td>

</tr>

{{ end }}

</table>

{{ end }}

提示:模板文件中,占位符取值,取的是prometheus的rules文件中对应的值,你可以先写好prometheus的规则文件后,再来编写模板文件

3、启动容器

# 启动alertmanager (启动后docker ps检查一下,确保alertmanager起来了即可)

docker run -d --name=alertmanager \

-p 9093:9093 \

-v /etc/localtime:/etc/localtime:ro \

-v /usr/local/alertmanager/config/alertmanager.yml:/etc/alertmanager/alertmanager.yml \

-v /usr/local/alertmanager/template:/etc/alertmanager/template \

prom/alertmanager:v0.25.0

1234567

4、查看alertmanager是否启动

# 查看一下docker容器

docker ps

# 再看一下alertmanager的日志

docker logs alertmanager

5、集成prometheus

- 编辑配置文件

vim /usr/local/prometheus/config/prometheus.yml

# 启用alertmanager

alerting:

alertmanagers:

- static_configs:

- targets:

# alertmanager的地址

- 192.168.0.106:9093

- 增加prometheus预警规则

vim /usr/local/prometheus/rules/os.rules

# 因为我们启动prometheus时,是挂载了宿主机的/usr/local/prometheus/rules目录到/prometheus/rules下,且配置了/prometheus/rules目录下所有的.rules文件都会被作为规则文件的

# 所以我们只需要将规则文件创建到宿主机的/usr/local/prometheus/rules目录下即可

groups:

- name: os

rules:

# prometheus是通过对应exporter的metric指标查询接口获取到被监测对象的数据的。当这个接口调用不通(或调用出错时),会认为up == 0,当持续时间满足for时,会发出对应的节点宕机预警

# 实际上,exporter的指标查询接口调不通,也可能是因为超时或者其它什么导致的,并不一定是被监控节点down机了

- alert: instance不可用(宕机或忙)告警

expr: up == 0

for: 1m

labels:

alarmClassify: normal

annotations:

summary: "监控程序{{ $labels.job }}所监控机器不可用"

description: "监控程序 {{ $labels.job }}(监控程序地址为{{ $labels.instance }}) down机超过1分钟了"

- alert: CPU告警

expr: 100-(avg(irate(node_cpu_seconds_total{mode="idle"}[5m])) by(instance)* 100) > 90

for: 5m

labels:

alarmClassify: normal

annotations:

summary: "CPU告警:CPU使用大于90%(目前使用:{{$value}}%)"

description: "CPU告警:监控程序{{$labels.instance}}所监控机器的CPU使用大于90%(目前使用:{{$value}}%). 已经持续5分钟了"

- alert: 内存告警

expr: 100 - ((node_memory_MemAvailable_bytes * 100) / node_memory_MemTotal_bytes) > 90

for: 30m

labels:

alarmClassify: normal

annotations:

summary: "内存告警:内存使用大于80%(目前使用:{{$value}}%)"

description: "内存告警:监控程序{{$labels.instance}}所监控机器的内存使用大于80%(目前使用:{{$value}}%)"

- alert: 磁盘分区使用率报警

expr: 100 - ((node_filesystem_avail_bytes{fstype=~"rootfs|xfs",mountpoint=~"/|/etc/hosts"} * 100) / node_filesystem_size_bytes{fstype=~"rootfs|xfs",mountpoint=~"/|/etc/hosts"}) > 80

for: 1m

labels:

alarmClassify: normal

annotations:

summary: "磁盘分区告警:{{$labels.mountpoint}} 磁盘分区使用大于80%(目前使用:{{$value}}%)"

description: "磁盘分区告警:监控程序{{$labels.instance}}所监控机器的磁盘分区使用量大于80%(目前使用:{{$value}}%). 其它信息:device:{{$labels.device}}, mount:{{$labels.mountpoint}} "

- alert: 挂载磁盘分区使用率报警

expr: 100 - ((node_filesystem_avail_bytes{mountpoint=~"/rootfs/newDisk|/backup"} * 100) / node_filesystem_size_bytes{mountpoint=~"/rootfs/newDisk|/backup"}) > 80

for: 1m

labels:

alarmClassify: normal

annotations:

summary: "挂载磁盘分区告警:{{$labels.mountpoint}} 挂载磁盘分区使用大于80%(目前使用:{{$value}}%)"

description: "挂载磁盘分区告警:监控程序{{$labels.instance}}所监控机器的挂载磁盘分区使用量大于80%(目前使用:{{$value}}%). 其它信息:device:{{$labels.device}}, mount:{{$labels.mountpoint}} "

- alert: IO性能

expr: ((irate(node_disk_io_time_seconds_total[30m]))* 100) > 95

for: 1m

labels:

alarmClassify: normal

annotations:

summary: "{{$labels.mountpoint}} 流入磁盘IO使用率过高"

description: "监控程序{{$labels.instance}}所监控机器的{{$labels.mountpoint }}流入磁盘IO大于95%(目前使用:({{$value}}))"

- alert: 网络(入)

expr: ((sum(rate (node_network_receive_bytes_total{device!~'tap.*|veth.*|br.*|docker.*|virbr*|lo*'}[5m])) by (instance)) / 100) > 10240

for: 5m

labels:

alarmClassify: normal

annotations:

summary: "{{$labels.mountpoint}} 流入网络带宽过高"

description: "监控程序{{$labels.instance}}所监控机器的 {{$labels.mountpoint }} 流入网络带宽持续5分钟高于10M. RX带宽使用率{{$value}}"

- alert: 网络(出)

expr: ((sum(rate (node_network_transmit_bytes_total{device!~'tap.*|veth.*|br.*|docker.*|virbr*|lo*'}[5m])) by (instance)) / 100) > 10240

for: 5m

labels:

alarmClassify: normal

annotations:

summary: "{{$labels.mountpoint}} 流出网络带宽过高"

description: "监控程序{{$labels.instance}}所监控机器的 {{$labels.mountpoint }} 流出网络带宽持续5分钟高于10M. RX带宽使用率{{$value}}"

# 重启容器prometheus

docker restart prometheus

# 查看日志

docker logs prometheus

6、验证预警

访问prometheus,ip:9090,查看预警规则是否有了

预警状态说明:

- Inactive:未触发预警

- Pending:满足预警规则里面的预警表达式expr了,但是持续时间不满足预警规则里面的for,尚未发送预警信息

- Firing:触发预警且已发送预警信息

- 感谢你赐予我前进的力量

.gif)